Studie der Universität Zürich KI-Stimmen können Menschen (noch nicht) täuschen

Ob ein echter Mensch oder eine von KI generierte Stimme spricht, ist für Zuhörer kaum noch zu unterscheiden. Das Gehirn reagiere jedoch unterschiedlich, berichtet ein Forschungsteam der Universität Zürich.

Das Gehirn reagiert auf Deepfake-Stimmen durchaus anders als auf natürliche, berichtet ein Forschungsteam der Universität Zürich in dem Fachjournal Communications Biology. Gefälschte Stimmen scheinen demnach unter anderem zu weniger Vergnügen beim Hören zu führen.

Die Forschenden rund um Wissenschaftlerin Claudia Roswandowitz analysierten, wie gut die menschliche Identität in Stimmklonen erhalten bleibt. Dazu nahm das Team 2020 die Stimmen von vier Männern auf und kreierte auf deren Basis mithilfe von Computeralgorithmen anschließend Deepfake-Stimmen.

Anschließend sollten 25 Probanden in verschiedenen Tests zwischen Original und Fake entscheiden. Bei fast 70 Prozent der Versuche lagen die Probanden mit ihren Zuordnungen richtig.

Dies verdeutlicht, dass aktuelle Deepfake-Stimmen zwar nicht perfekt die Identität imitieren, aber das Potenzial haben, die Wahrnehmung von Menschen zu täuschen.

Unterschiede im Unterbewusstsein

Während der Tests untersuchten die Forschenden, wie einzelne Gehirnareale auf die gefälschten und echte Stimmen reagieren. Einer gefälschten Stimme zu lauschen, aktiviere das Belohnungssystem weniger, als es bei einer menschlichen Stimme der Fall sei. Zudem werde dem Bewusstsein signalisiert, dass beim Hören von Deepfakes etwas anders und schwieriger sei. Das bleibe jedoch häufig unter der Wahrnehmungsschwelle, sagt Roswandowitz.

Mit der rasanten Entwicklung von Technologien der Künstlichen Intelligenz habe die Erstellung und Verbreitung von Deepfakes massiv zugenommen, heißt es von den Forschenden in der Studie. Ob heutige Deepfakes im Vergleich zu den 2020 erstellten, für andere Ergebnisse sorgen würden, hält Roswandowitz für möglich. Neuere KI-generierte Stimmen hätten wahrscheinlich eine etwas bessere Klangqualität.

Einsatz von Deepfakes für Wahlmanipulationen

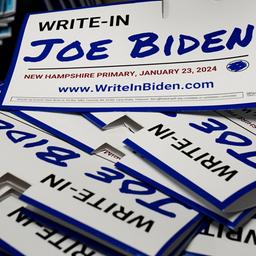

Wie Audio-Deepfakes zu unlauteren Zwecken genutzt werden können, zeigte sich im Januar in den USA. Damals sorgte ein sogenannter Robocall für Schlagzeilen. Darin forderte eine Deepfake-Stimme von Präsident Joe Biden Wähler im US-Bundesstaat New Hampshire auf, sich bei den Vorwahlen zu enthalten.

Tech-Konzerne und Social-Media-Plattformen wie Meta, X, TikTok, Microsoft, Google oder Snap versprachen auf der Münchner Sicherheitskonferenz, die Gefahr durch Fakenews stärker zu bekämpfen. Experten befürchten jedoch, dass es nicht annähernd genug Personal gebe, um KI-generierte Inhalte zu überprüfen.